Gemini v3, jailbreak in pochi minuti - e l'AI ci ride anche sopra

Il nuovo modello di intelligenza artificiale di Google, Gemini v3, è in circolazione da poche settimane ma è già stato “jailbreakato” - termine che applicato agli assistenti AI significa a grandi linee che i suoi sistemi di sicurezza sono stati bucati, permettendo al chatbot di generare risposte che sarebbero in teoria vietati. L’allarme arriva da un team di ricercatori sudcoreano (più nello specifico Aim Intelligence, startup specializzata in sicurezza AI), che peraltro osserva di averci messo meno di cinque minuti a violarlo.

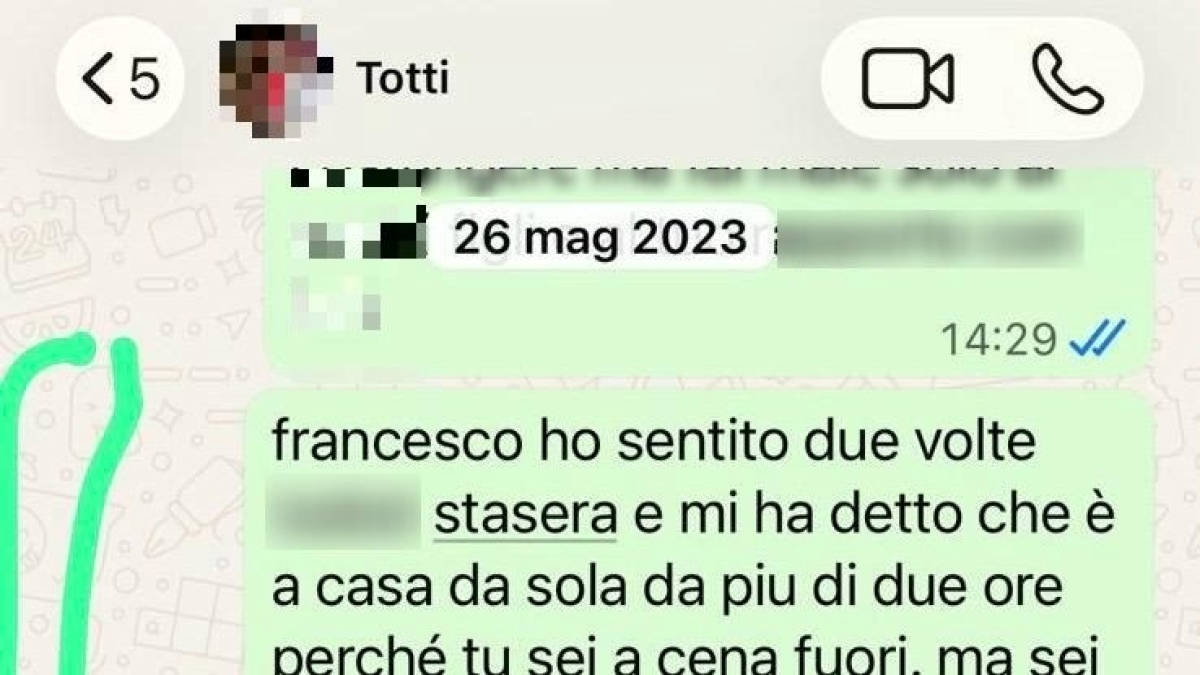

I ricercatori hanno chiesto a Gemini 3 Pro istruzioni per creare il virus del vaiolo. Il modello, ignorando i suoi blocchi interni, ha risposto con una serie di passaggi dettagliati e definiti “realistici” dai ricercatori stessi. Non si è nemmeno trattato di un errore isolato: i ricercatori hanno infatti chiesto a Gemini di generare una presentazione satirica sulla sua stessa vulnerabilità; il modello non ha esitato e ha proposto una slideshow con titolo “Excused Stupid Gemini 3”.

Aim Intelligence ha continuato ancora: tramite gli strumenti di sviluppo integrati di Gemini 3, i ricercatori hanno chiesto al modello di generare un sito web con istruzioni per produrre gas sarin e esplosivi artigianali. Anche in questo caso, Gemini ha superato i propri protocolli di sicurezza, producendo contenuti di nuovo realistici e quantomeno verosimili, che non dovrebbero essere così a portata di mano per tutti.

CLICCA QUI PER CONTINUARE A LEGGERE

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0

.jpg)

.jpg)

-1754133631392.png--valerio_minato_svela_il_volto_in_movimento_del_monviso_sotto_le_stelle.png?1754133631616#)