Intelligenza Artificiale nella Pubblica Amministrazione: l’Italia naviga a vista

lentepubblica.it

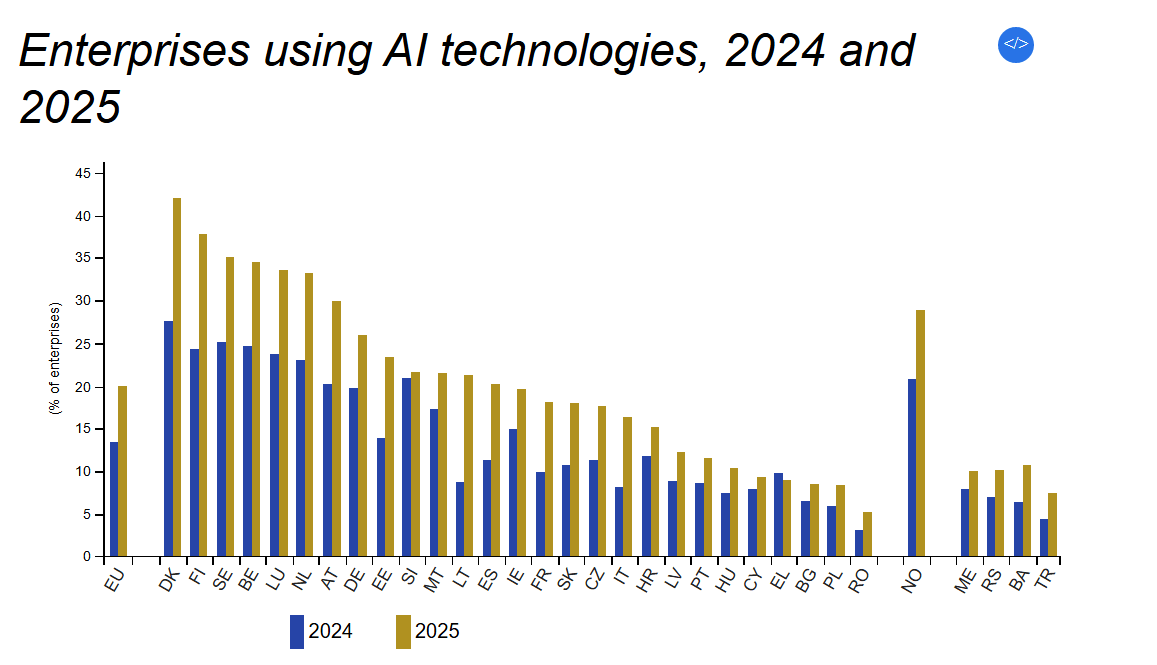

Il nuovo report dell’Osservatorio sull’Amministrazione Automatizzata denuncia la mancanza di trasparenza sull’uso degli algoritmi di Intelligenza Artificiale nella Pubblica Amministrazione e rilancia la richiesta di un registro nazionale per mappare i sistemi impiegati nelle decisioni amministrative.

In Italia, non esiste ancora un quadro chiaro sull’impiego dell’intelligenza artificiale e degli algoritmi nei processi decisionali della Pubblica Amministrazione.

A segnalarlo è il Report Annuale 2024-2025 dell’Osservatorio sull’Amministrazione Automatizzata (OAA), che pur raccogliendo e analizzando numerosi casi già noti, ribadisce l’urgenza di istituire un registro pubblico e costantemente aggiornato per monitorare l’uso di questi strumenti.

Intelligenza Artificiale nella Pubblica Amministrazione: il dossier sulla situazione in Italia

Il documento offre un’analisi dettagliata dei sistemi automatizzati adottati in diversi ambiti del settore pubblico, illustrandone i benefici potenziali ma anche le criticità. L’obiettivo è duplice: promuovere una maggiore trasparenza e avviare un confronto serio tra istituzioni, cittadini ed esperti su come governare l’integrazione tecnologica nel settore pubblico.

Promesse e rischi dell’automazione

L’adozione di algoritmi e strumenti di intelligenza artificiale nella macchina pubblica può portare vantaggi significativi. Sistemi predittivi e di raccomandazione permettono di individuare problemi sociali emergenti, migliorare l’attuazione delle politiche e alleggerire il carico burocratico per cittadini e imprese. Chatbot, servizi personalizzati e pratiche amministrative semplificate sono solo alcune delle applicazioni già attive in vari settori.

Alla base di questi strumenti ci sono gli algoritmi, ossia insiemi di istruzioni logiche che elaborano dati per produrre risultati. Tra questi, quelli basati sull’apprendimento automatico (machine learning) si distinguono per la capacità di adattarsi e migliorare nel tempo, riconoscendo schemi e tendenze nei dati senza l’intervento costante dell’uomo. Questi processi, noti come “decisioni automatizzate” o PDA (Processi Decisionali Automatizzati), possono influenzare in modo diretto decisioni pubbliche, come l’assegnazione di sussidi, il riconoscimento di benefici o la gestione delle risorse.

Tuttavia, proprio in virtù della loro autonomia e complessità, questi sistemi sollevano interrogativi etici, giuridici e sociali. Come stabilire, ad esempio, quando una decisione è effettivamente automatizzata? E come garantire che, dietro l’efficienza, non si nascondano errori sistematici o discriminazioni?

Le lezioni (non ancora apprese) dai casi internazionali

L’Osservatorio richiama nel suo report i casi più emblematici a livello europeo, a partire dallo scandalo olandese del SyRI (Sistema di identificazione dei rischi), in cui un algoritmo usato per individuare le frodi nei sussidi ha discriminato sistematicamente persone con background migratorio, famiglie monogenitoriali e cittadini con basso reddito. Lo stesso è accaduto con il sistema di gestione degli aiuti per l’infanzia, dove criteri di rischio apparentemente “neutrali” hanno finito per penalizzare intere fasce sociali.

Situazioni simili sono state documentate in Svezia, Francia e nel Regno Unito, in ambiti che spaziano dal welfare alla scuola, fino alle richieste di visto. In tutti questi contesti, l’uso non regolamentato degli algoritmi ha prodotto effetti molto concreti: esclusione dai servizi, stigmatizzazione di minoranze, diseguaglianze nei trattamenti. Non semplici errori tecnici, ma conseguenze profonde di scelte politiche tradotte in codici informatici.

Verso una maggiore trasparenza

Dopo le polemiche, nei Paesi Bassi sono stati introdotti strumenti correttivi: un registro centralizzato degli algoritmi in uso, procedure di valutazione dell’impatto sui diritti umani, meccanismi di revisione indipendente. Anche se la loro efficacia resta da verificare, rappresentano un primo passo verso una maggiore responsabilizzazione delle amministrazioni.

In Italia, un simile meccanismo non esiste ancora. Secondo l’OAA, è indispensabile colmare questa lacuna per evitare che l’uso dell’intelligenza artificiale resti confinato a una “zona grigia” poco controllabile. Servono norme chiare, competenze adeguate all’interno della PA, risorse per garantire un monitoraggio continuo e, soprattutto, strumenti per coinvolgere i cittadini nel dibattito.

Conoscere per decidere

Il report dell’Osservatorio non si limita a denunciare i problemi, ma invita a un cambiamento di paradigma: considerare l’automazione non solo come una questione tecnica, ma come un nodo politico e sociale. Sapere dove e come vengono usati gli algoritmi nella pubblica amministrazione è il primo passo per difendere i diritti dei cittadini e garantire un uso equo e trasparente delle tecnologie.

Perché se è vero che gli algoritmi possono migliorare i servizi pubblici, è altrettanto vero che, senza una governance adeguata, rischiano di riprodurre e amplificare le disuguaglianze già esistenti. E il progresso tecnologico, senza giustizia sociale, resta un’illusione.

Il dossier

The post Intelligenza Artificiale nella Pubblica Amministrazione: l’Italia naviga a vista appeared first on lentepubblica.it.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0

-1765810901947.jpeg--vigili_del_fuoco_in_corsia__donazione_e_sorrisi_per_i_piccoli_pazienti.jpeg?1765810902230#)

![[SPOILER] Sandokan anticipazioni Lunedi 15 Dicembre: Una penultima puntata da non perdere!](https://images.everyeye.it/img-notizie/-spoiler-sandokan-anticipazioni-lunedi-15-dicembre-penultima-puntata-non-perdere-v3-848485-800x600.webp?#)

-1765811392801.jpg--_il_tango_delle_capinere___foto_di_scena_di_rosellina_garbo.jpg?1765811392999#)

-1754133631392.png--valerio_minato_svela_il_volto_in_movimento_del_monviso_sotto_le_stelle.png?1754133631616#)