Gli AirPods del futuro potrebbero leggere i segnali cerebrali: lindizio da uno studio Apple

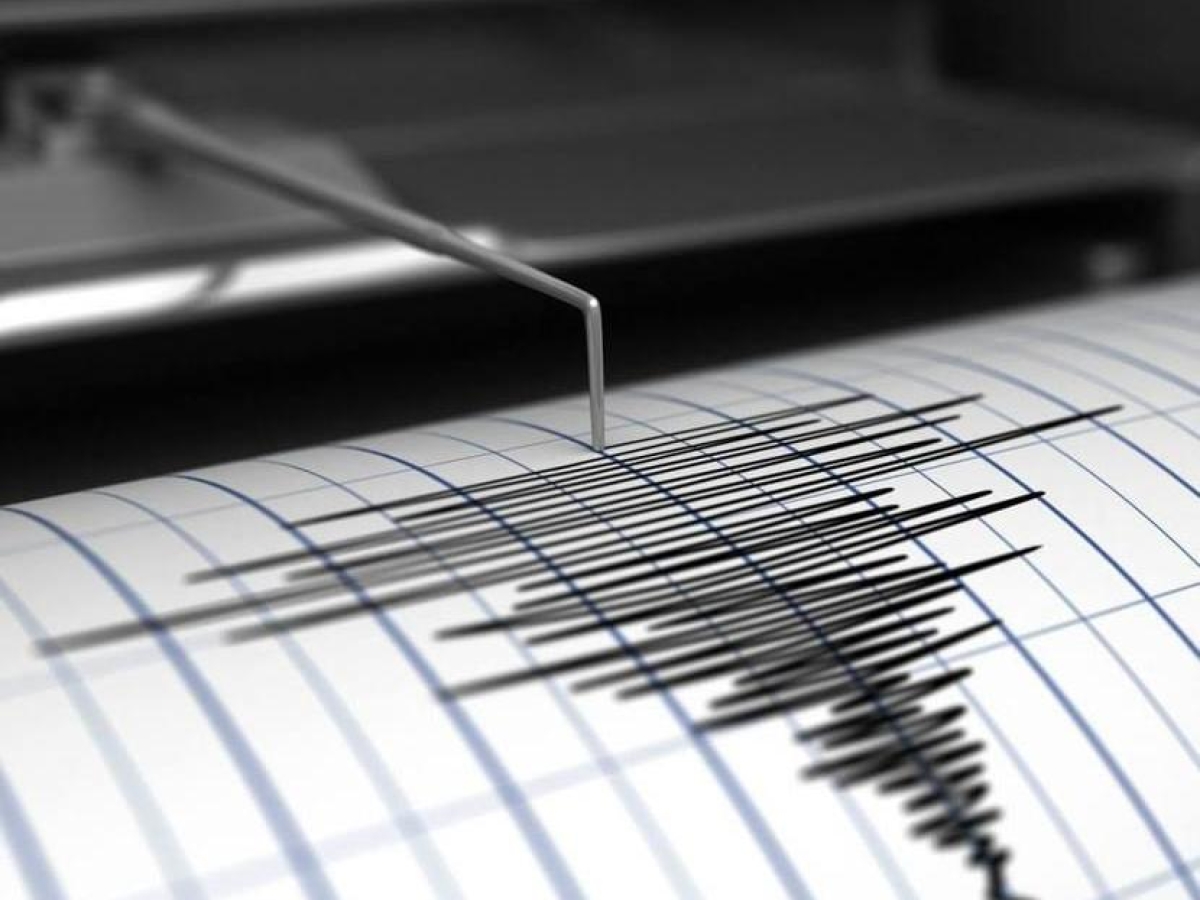

Apple torna a interessarsi in modo concreto allo studio dei segnali cerebrali, e lo fa con una ricerca che sposta l’attenzione dalla quantità di dati etichettati necessari per analizzare un tracciato EEG al modo in cui un modello di AI potrebbe imparare direttamente dalla struttura temporale del segnale. Il lavoro, intitolato Learning the relative composition of EEG signals using pairwise relative shift pretraining, introduce un metodo chiamato PARS — acronimo di PAirwise Relative Shift — pensato per capire come due frammenti di attività elettrica cerebrale si posizionino l’uno rispetto all’altro nel tempo.

In pratica, invece di spiegare al modello cosa rappresenti ogni fase dell’EEG (sonno REM, stadi Non-REM, o l’inizio di un evento epilettico), il sistema impara autonomamente a dedurre gli spostamenti temporali tra segmenti casuali del segnale. Questo approccio, basato su autoapprendimento, evita la necessità di migliaia di ore di tracciati annotati manualmente da esperti, uno dei maggiori ostacoli nello sviluppo di algoritmi affidabili per l’elettroencefalografia.

La differenza rispetto ai metodi più diffusi è sostanziale: mentre le tecniche di autoencoder mascherati si concentrano sulle piccole porzioni mancanti di un segnale, PARS invita il modello a cogliere l’architettura più ampia del tracciato, quelle dipendenze a lungo raggio che caratterizzano la dinamica cerebrale. Nei test condotti su quattro diversi dataset, il metodo ha superato — o almeno eguagliato — le prestazioni degli approcci più affinati oggi disponibili, mostrando un vantaggio particolare nelle condizioni in cui le etichette sono poche o assenti.

CLICCA QUI PER CONTINUARE A LEGGERE

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0

-1754133631392.png--valerio_minato_svela_il_volto_in_movimento_del_monviso_sotto_le_stelle.png?1754133631616#)