Deepfake istituzionali e truffe milionarie: l’IA sta ingannando anche gli utenti più esperti

lentepubblica.it

Fanno discutere sempre di più i casi di vere e proprie truffe con estorsioni esorbitanti a utenti comuni legate a Deepfake creati con l’IA: qual è la situazione attuale? Stanno seriamente diventando così realistici da gabbare anche gli internauti più esperti?

“Il successo nella creazione dell’intelligenza artificiale potrebbe essere il più grande evento nella storia umana. Purtroppo, potrebbe anche essere l’ultimo, a meno che non impariamo a evitarne i rischi.”, diceva, non molto tempo fa, lo scienziato Stephen Hawking, in occasione dell’evento inaugurale, nel 2016, del Leverhulme Centre for the Future of Intelligence (CFI) dell’Università di Cambridge.

Rischi che, a giudicare dall’impressionante evoluzione della sicurezza cibernetica e dalla diffusione di forme sempre più articolate ed efficienti di manipolazione sintetica e di criminalità informatica, non sembra siamo del tutto in grado di evitare.

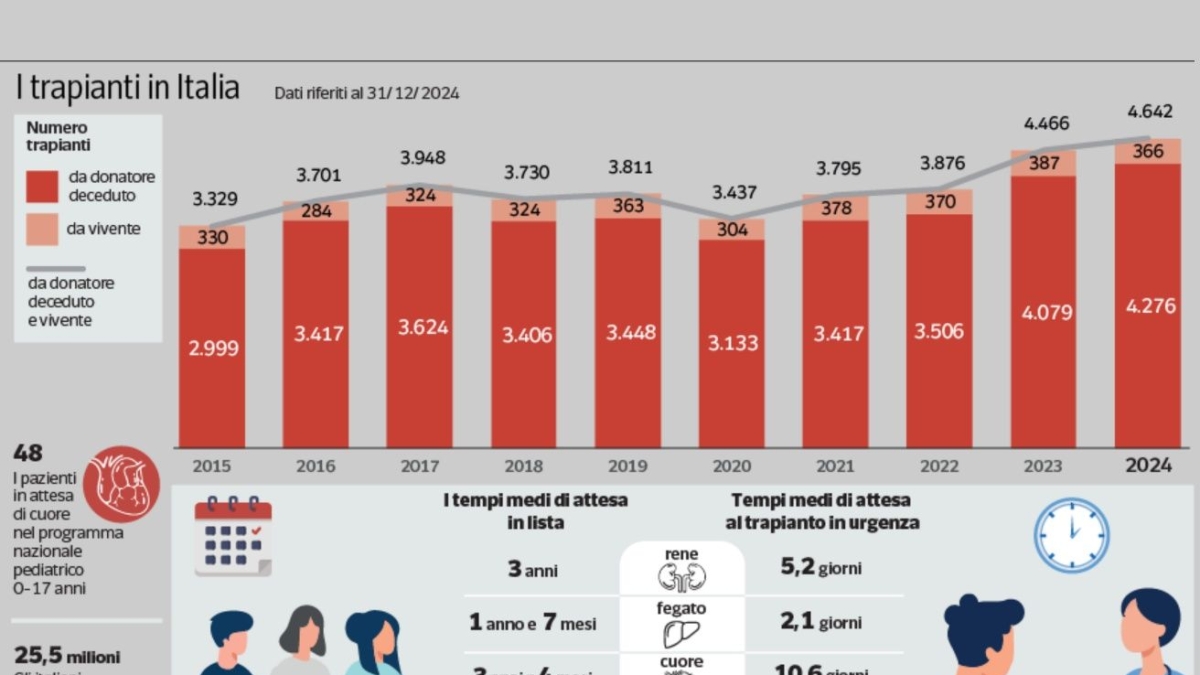

Sono passati appena 10 anni dalla citazione riportata in apertura e, secondo i dati raccolti dalla Polizia Postale per il Nord-Ovest del nostro Paese, campeggia una voragine economica da 26 milioni di euro solo nel 2025, alimentata da un traffico social dove i contenuti sintetici rappresentano ormai una quota stimata vicina al 20% del totale.

Il caso dei deepfake istituzionali e delle truffe milionarie legate all’utilizzo illegale dell’IA

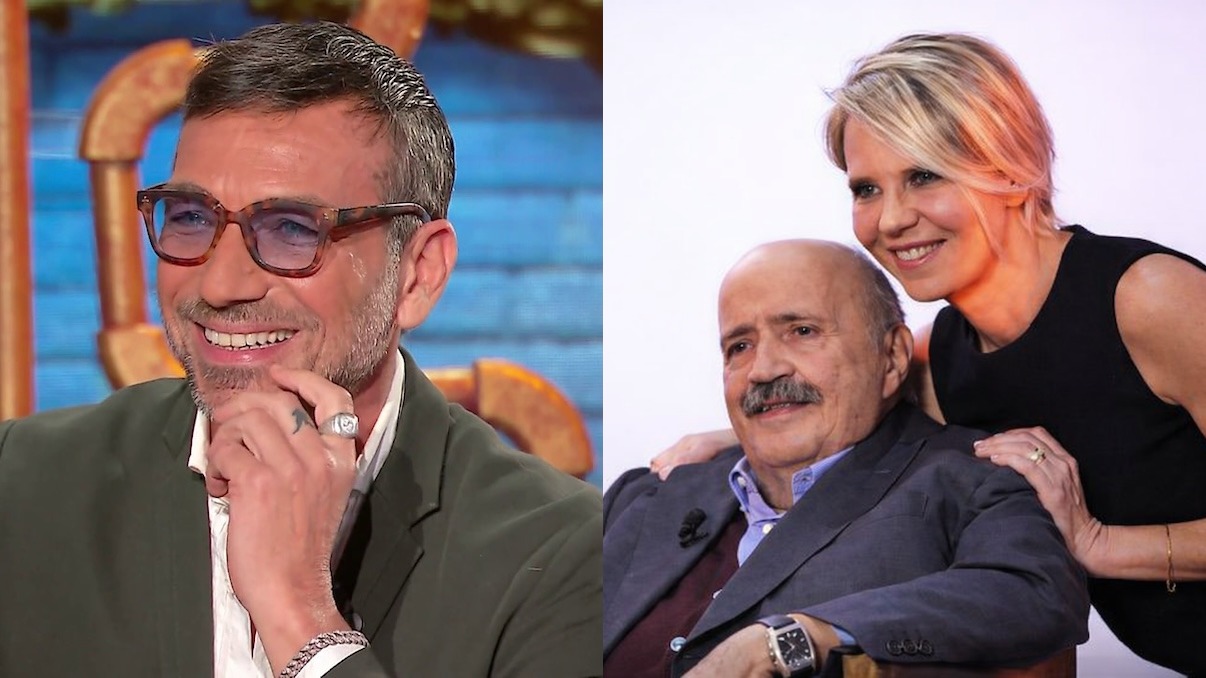

L’episodio che ha coinvolto un professionista di Torino, vittima di una frode da 700.000 euro, rappresenta un caso di studio fondamentale per comprendere la pericolosità dei deepfake istituzionali. I criminali hanno utilizzato l’immagine e la voce della premier Giorgia Meloni e del giornalista Sigfrido Ranucci per dare credibilità a piattaforme di investimento fittizie.

Ne avevamo parlato e riportato ad esempio il video fake della premier in un nostro post sulla nostra pagina Instagram che potete rivedere qui di seguito.

La potenza di questa tecnica risiede nella capacità di bypassare i filtri critici del cervello umano attraverso il principio di autorità: vedere un volto noto che parla con la sua reale inflessione vocale genera una fiducia immediata. Questi contenuti vengono distribuiti attraverso campagne mirate, inducendo le vittime a versare somme crescenti in asset digitali su portali controllati dai truffatori, spesso simulando persino videochiamate in diretta per azzerare ogni forma di diffidenza residua.

I segnali rivelatori dell’Intelligenza Artificiale

Nonostante i modelli generativi abbiano compiuto passi da gigante, il riconoscimento dei video sintetici è possibile se si sposta l’attenzione sui dettagli di coerenza fisica e logica. Ad esempio, le mani spesso manifestano anomalie nelle articolazioni, con dita che possono fondersi o cambiare forma durante gesti complessi. Anche la simulazione della luce resta un punto critico: i modelli AI faticano a gestire ombre multiple e riflessi coerenti su superfici metalliche. Osservando il video a velocità ridotta, emergono spesso “glitch” di continuità dove orecchie e profili si deformano, rendendo palese la natura “artificiale” del contenuto.

Il paradosso dei chatbot e il fallimento del rilevamento automatico

Un dato allarmante emerso dalle recenti ricerche di NewsGuard evidenzia come persino i sistemi di intelligenza artificiale più avanzati, come Grok, ChatGPT e Gemini, fatichino a identificare i video prodotti dalle loro stesse tecnologie. In assenza di watermark digitali espliciti (le cd. filigrane), i tassi di fallimento nel riconoscimento del falso sono estremamente alti, superando il 90% in alcuni casi. Questo significa che l’utente non può fare affidamento sugli stessi strumenti digitali per validare ciò che vede; la distinzione tra reale e sintetico sta diventando sempre meno una questione tecnica e sempre più una competenza culturale e critica del cittadino.

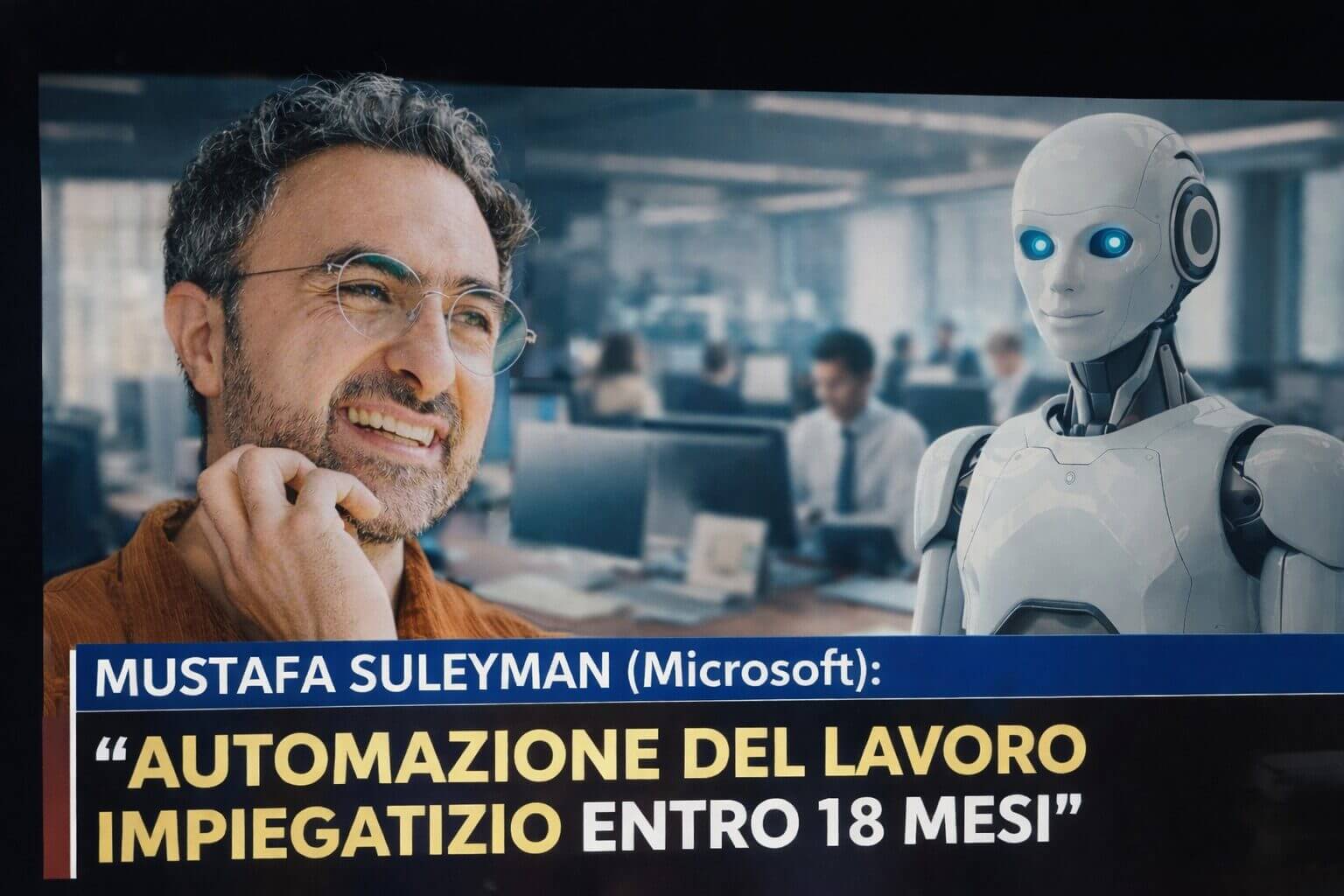

Esempi virali del 2025, come i conigli che saltano su un trampolino o l’anziana che interagisce con un orso sul portico, dimostrano come questi contenuti vengano creati con l’unico scopo di macinare engagement attraverso l’empatia o lo stupore. La comparsa di “quasi cloni” dello stesso video, con variazioni minime, è un segnale tipico della produzione seriale di contenuti sintetici. Più grave è l’uso bellico o politico, come il celebre deepfake di Zelensky che invitava alla resa, o le finte dirette su YouTube dove cloni di leader del settore tech, come Jensen Huang di NVIDIA, promuovono truffe legate alle criptovalute tramite codici QR sovrapposti a video rubati da eventi reali.

Il Deep Web: tra pedopornografia e cyberbullismo

Parallelamente alle frodi finanziarie, la Polizia Postale combatte quotidianamente contro reati particolarmente gravi che colpiscono la dignità e la sicurezza dei minori. Il monitoraggio del deep web rimane un’attività prioritaria per contrastare la pedopornografia online, un fenomeno che nel solo 2025 ha portato all’arresto di 14 individui e alla denuncia di decine di soggetti insospettabili, sorpresi a scambiare materiale pedopornografico spesso caratterizzato da scene di violenza.

Allo stesso modo, le nuove tecnologie sono diventate il vettore principale del cyberbullismo, una piaga che corre velocemente tra i giovani e che richiede un aggiornamento costante delle tecniche di investigazione digitale per proteggere le vittime dalle persecuzioni sistematiche agite attraverso piattaforme social e canali di messaggistica criptati.

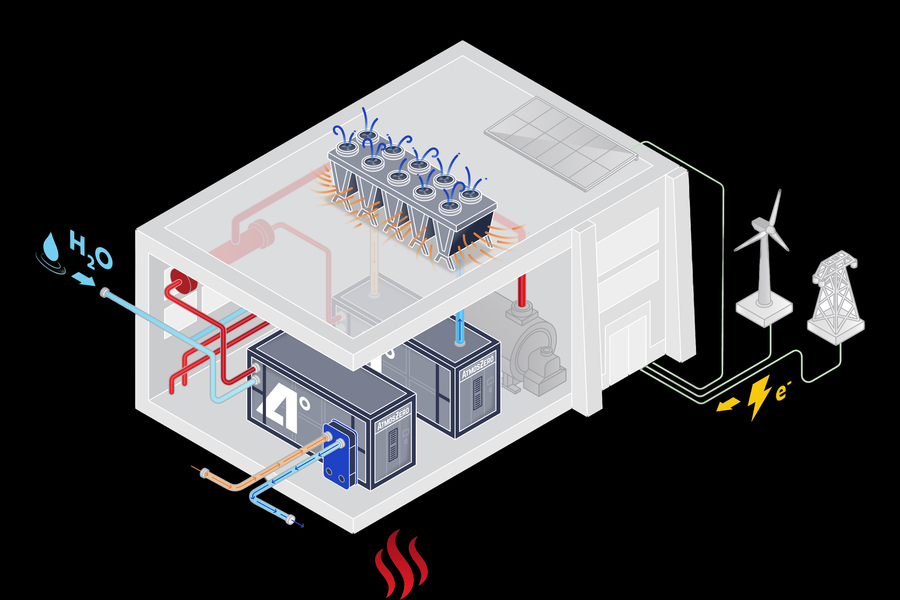

La difesa tramite protocolli e prevenzione

La risposta istituzionale alla minaccia cibernetica si articola su una rete di cooperazione che coinvolge i nodi strategici del territorio. Per difendere le infrastrutture critiche e i dati dei cittadini, la Polizia Postale ha stipulato protocolli di sicurezza specifici con enti di primaria importanza come il Gruppo Torinese Trasporti (GTT), l’Università degli Studi e MSC, creando uno scudo digitale contro potenziali attacchi hacker e intrusioni di sistema.

Questa struttura difensiva ha permesso di diramare oltre 500 alert di sicurezza nell’ultimo anno, prevenendo violazioni che avrebbero potuto paralizzare servizi essenziali. A questo impegno tecnico si affianca una massiccia attività di prevenzione nelle scuole, volta a formare una consapevolezza critica sin dalle elementari per mitigare i rischi legati all’interazione sociale online.

Il filtro del contesto e la competenza culturale del cittadino

Le istituzioni europee sottolineano che, nell’era della disinformazione sintetica, il filtro più efficace resta il giudizio umano. Chiedersi chi ha prodotto un video e con quale obiettivo è spesso più utile che cercare il singolo difetto grafico. Un filmato che mostra “appelli umanitari” virali privi di una fonte verificabile è spesso il prodotto di una generazione algoritmica progettata per trarre in inganno gli utenti del web. L’unica vera difesa consiste nel mantenere un certo scetticismo rispetto a contenuti che possono sembrare strani o poco attendibili, affidandosi a fonti ufficiali.

The post Deepfake istituzionali e truffe milionarie: l’IA sta ingannando anche gli utenti più esperti appeared first on lentepubblica.it.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0