Gemini ora "pensa" prima di guardare: Agentic Vision porta il ragionamento nel riconoscimento delle immagini

Una delle prossime frontiere dell'intelligenza artificiale è l'elaborazione visiva, con la capacità di gestire immagini sempre più complesse, senza perdere i dettagli essenziali. In questo contesto, l'arrivo di Agentic Vision dentro Gemini 3 Flash introduce un approccio che prova a ridurre gli errori legati ai particolari più minuti.

L'idea di fondo nasce dall'esigenza di evitare interpretazioni basate su supposizioni quando un'immagine contiene informazioni difficili da cogliere a colpo d'occhio. Con questo sistema, la comprensione visiva si trasforma in una sorta di indagine strutturata, che permette di ricavare risposte più aderenti ai contenuti originali.

Agentic Vision introduce un ciclo composto da tre fasi: Think, Act e Observe. Il modello elabora la richiesta e pianifica un percorso in più passaggi, esegue porzioni di codice Python per manipolare o analizzare l'immagine, quindi aggiunge il risultato nuovamente al proprio contesto per verificare ciò che ha scoperto.

Questa procedura permette di trasformare la lettura dell'immagine in un processo attivo, non più statico. La combinazione tra ragionamento visivo e codice favorisce un riscontro più solido con ciò che appare a schermo.

Secondo i dati condivisi, l'attivazione dell'esecuzione del codice porta un incremento medio della qualità compreso tra 5-10% nella maggior parte dei test dedicati alla visione.

Una delle applicazioni più evidenti riguarda lo zoom automatico sui dettagli difficili da distinguere. Viene riportato il caso di PlanCheckSolver.com, una piattaforma che valida progetti edilizi: il sistema analizza porzioni dell'immagine, ritaglia le aree rilevanti e le reinserisce nel proprio contesto, ottenendo un miglioramento della precisione del 5%.

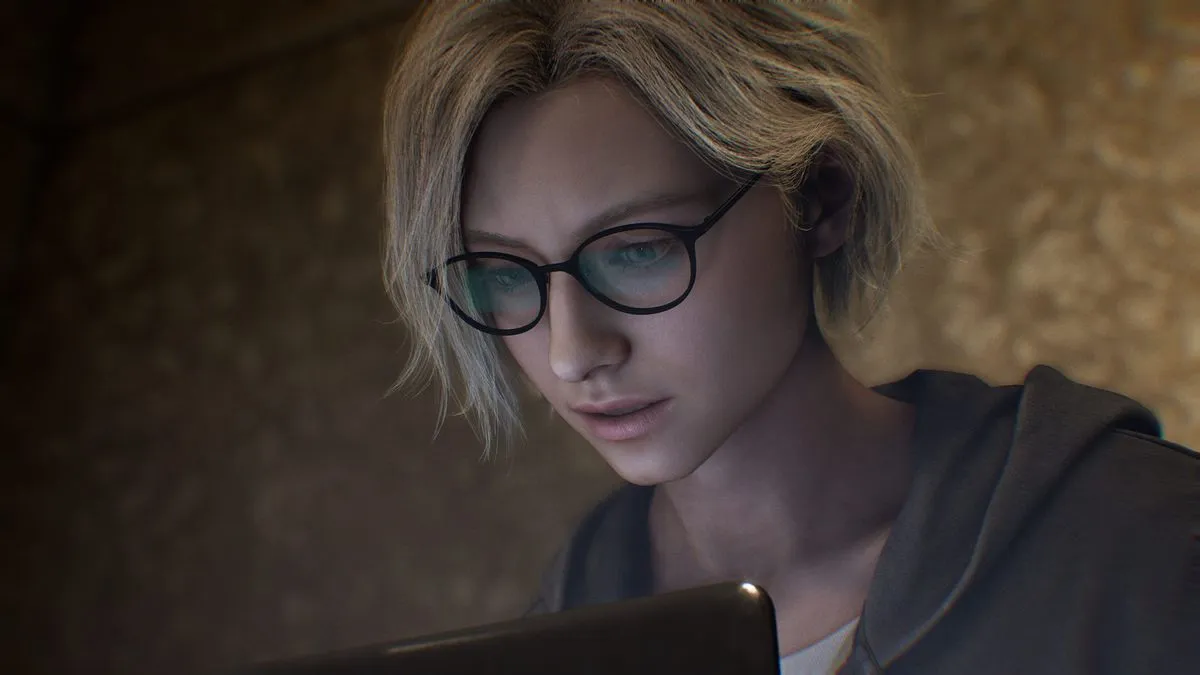

Un'altra funzione riguarda l'annotazione delle immagini. Il modello può disegnare riquadri, etichette numeriche e altri elementi grafici tramite codice Python, così da rendere esplicito il processo che porta alla risposta. L'esempio mostrato include il conteggio delle dita di una mano, svolto con un "taccuino visuale" che evita errori di interpretazione.

Agentic Vision gestisce anche operazioni di matematica visuale. Attraverso l'esecuzione di codice, il sistema analizza tabelle dense di numeri e genera grafici con Matplotlib, stabilizzando i calcoli ed evitando passaggi approssimativi.

Il progetto non si ferma qui. Sono previste funzioni implicite aggiuntive, come la possibilità di ruotare immagini o svolgere matematica visuale senza richiederlo esplicitamente. I lavori riguardano anche l'integrazione di nuovi strumenti, tra cui la ricerca web e la ricerca inversa delle immagini, oltre all'estensione della funzione ad altre dimensioni di modello.

Agentic Vision è disponibile tramite Gemini API in Google AI Studio e in Vertex AI, e sta iniziando a comparire anche nell'app Gemini selezionando la modalità Thinking dal menu dei modelli. La prova pratica è accessibile tramite la sezione Playground di AI Studio attivando la voce Code Execution.

Alla fine, l'impressione è quella di una funzione che spinge a guardare le immagini con meno fretta e con più metodo, un approccio che ha funzionato anche nei chatbot "ordinari": è un po' come far ragionare di più il modello, e non a caso è associata alla modalità thinking.

L'articolo Gemini ora "pensa" prima di guardare: Agentic Vision porta il ragionamento nel riconoscimento delle immagini sembra essere il primo su Smartworld.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0