Nell’era dell’intelligenza artificiale c’è un nuovo rischio per la sicurezza nucleare globale

Per decenni il pericolo più grande per la sicurezza nucleare è stato l’errore umano. Il rischio che qualcuno con accesso ai pulsanti delle testate più letali del mondo decidesse davvero di pigiarli. Il 2026 potrebbe essere l’anno in cui il rischio più grande si sposta dall’uomo alla macchina, magari una capace di convincere l’uomo a fare cose che altrimenti non avrebbe fatto. Nell’era dell’intelligenza artificiale generativa, dei deepfake e della disinformazione algoritmica, i sistemi di allerta nucleare – costruiti per reagire in pochi minuti – sono esposti a una nuova vulnerabilità: la possibilità che un’informazione falsa ma credibile venga scambiata per una minaccia atomica, e dia inizio a un’escalation.

Ne ha parlato Erin D. Dumbacher, Stanton Nuclear Security Senior Fellow al Council on Foreign Relations, in una lunga analisi pubblicata su Foreign Affairs. Un’argomentazione inquietante perché mostra come l’intelligenza artificiale non rappresenti solo un rischio futuro o teorico, ma una minaccia concreta alla stabilità strategica globale, soprattutto in un contesto politico in cui le garanzie istituzionali si stanno indebolendo.

L’analisi di Dumbacher poggia su un’evidenza storica precisa: in passato il mondo è già arrivato sull’orlo della guerra nucleare per un falso allarme. Nel settembre del 1983 un sistema sovietico di early warning segnalò erroneamente il lancio di missili statunitensi. Solo il sangue freddo dell’ufficiale Stanislav Petrov, che giudicò l’allarme poco credibile, evitò una risposta nucleare catastrofica.

Oggi, spiega Dumbacher, quel rischio è tornato, ma in una forma più subdola. I sistemi di allerta contemporanei non operano più in un ecosistema informativo controllato, bensì in un ambiente saturo di contenuti manipolabili, deepfake, segnali ambigui e analisi automatizzate. «L’intelligenza artificiale avrebbe già il potenziale per ingannare i principali decisori e i membri della catena di comando nucleare facendogli vedere un attacco che non c’è», scrive l’autrice.

Il problema non è solo l’uso diretto dell’intelligenza artificiale nei sistemi militari, ma il modo in cui essa può contaminare il processo decisionale nelle fasi iniziali di una crisi, quando ogni minuto e ogni singolo gesto contano. Qui entra in gioco il fattore politico. Dumbacher parte non a caso dalla presidenza di Donald Trump, individuata come punto di fragilità strutturale senza precedenti. L’attuale amministrazione americana è formata da una corte di personaggi più adatti alla Zanzara di Giuseppe Cruciani che al governo di un Paese civile, ma hanno in mano i codici dell’atomica. E per di più operano in un contesto informativo profondamente degradato. «Se la disinformazione riesce a ingannare il presidente degli Stati Uniti anche solo per pochi minuti, potrebbe significare un disastro per il mondo», scrive Dumbacher.

Trump, come sappiamo, usa abitualmente i social media come fonte informativa, rilancia contenuti manipolati e deepfake, e ha dimostrato una scarsa propensione a distinguere tra informazione verificata e propaganda. In uno scenario di “launch on warning”, in cui Stati Uniti e Russia possono rispondere a un presunto attacco prima che questo colpisca il territorio nazionale, anche una breve finestra temporale di confusione può risultare fatale. Un video falso, un audio manipolato, o un’analisi di un software di intelligenza artificiale soggetto a “allucinazioni” (qui spiegavamo perché questi errori sono fisiologici e statisticamente irrisolvibili) potrebbero innescare una catena irreversibile di azioni sconsiderate.

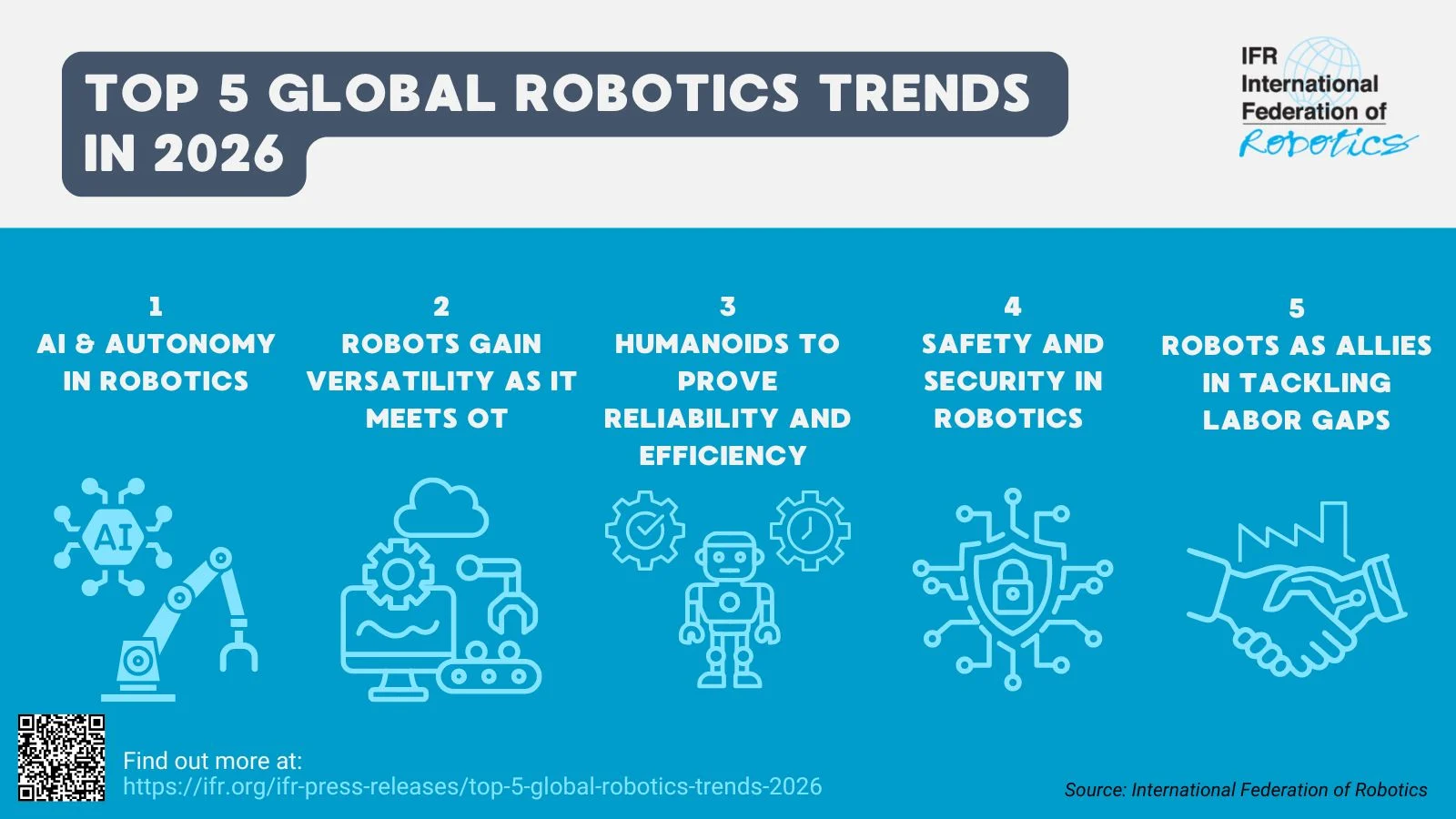

Il punto più controintuitivo dell’analisi di Foreign Affairs è che l’intelligenza artificiale viene spesso presentata come uno strumento per rendere i sistemi più sicuri e più rapidi. In realtà, nel dominio nucleare, velocità e automazione potrebbero essere un pericolo. I sistemi di early warning, spiega Dumbacher, non dispongono di dataset affidabili: non esistono abbastanza casi reali di attacchi nucleari da addestrare modelli robusti. «Qualsiasi sistema di rilevamento nucleare basato sull’intelligenza artificiale dovrebbe probabilmente essere addestrato su dati sintetici», si legge nell’articolo, aumentando il rischio di falsi positivi. E poiché il funzionamento interno dei modelli è opaco, gli operatori umani tendono a fidarsi dell’output della macchina, soprattutto in situazioni di grande stress.

È lo stesso meccanismo che, avvertiva Chatham House in un’analisi dello scorso giugno, rende le reti neurali inadatte alle decisioni ad alto rischio. «Un rischio importante è che l’intelligenza artificiale prenda la decisione sbagliata e che gli operatori umani non abbiano tempo o informazioni sufficienti per contestare tale decisione», scriveva Marion Messmer.

A rendere il quadro ancora più instabile è la dimensione informativa. Secondo la rivista scientifica Nature, intelligenza artificiale e disinformazione stanno moltiplicando il rischio nucleare, rendendo più opaca la comprensione delle intenzioni dei vari Paesi, creando sospetti e timori in una politica globale ad altissima competizione – soprattutto tra superpotenze. Di recente, durante gli scontri tra India e Pakistan nel Kashmir, flussi di immagini false e notizie manipolate hanno saturato i media di entrambi i Paesi, aumentando il rischio di escalation. «La deterrenza nucleare dipende sempre da una chiara comprensione delle capacità e delle intenzioni dell’avversario», ricorda Nature. Se quella chiarezza viene meno, il deterrente si trasforma in una trappola.

Purtroppo la politica nucleare delle grandi potenze, compresi gli Stati Uniti, è rimasta ancorata agli anni Ottanta, mentre l’ecosistema informativo e tecnologico è radicalmente cambiato. Nel 2025 il mondo dovrebbe aver imparato una lezione dall’enorme mole di disinformazione e di falsi in circolazione: servono nuove regole, nuovi contrappesi istituzionali e un’affermazione più netta di un principio cardine della deterrenza nucleare, cioè che una macchina non prenderà mai una decisione di lancio nucleare senza il controllo umano.

L'articolo Nell’era dell’intelligenza artificiale c’è un nuovo rischio per la sicurezza nucleare globale proviene da Linkiesta.it.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0

_(20)-1768127423519.jpg--controlli_in_zona_aurora__sequestri_di_droga_e_alimenti_abusivi.jpg?1768127423667#)

_(17)-1768123566628.jpg--fringe_benefit_2026__bonus_confermati_fino_a_2_000_euro__stop_all_agevolazione_per_i_neoassunti.jpg?1768123566762#)

_(21)-1768128936706.jpg--incendio_boschivo_a_condove__fiamme_domate_grazie_all_intervento_coordinato_dei_soccorsi.jpg?1768128936869#)