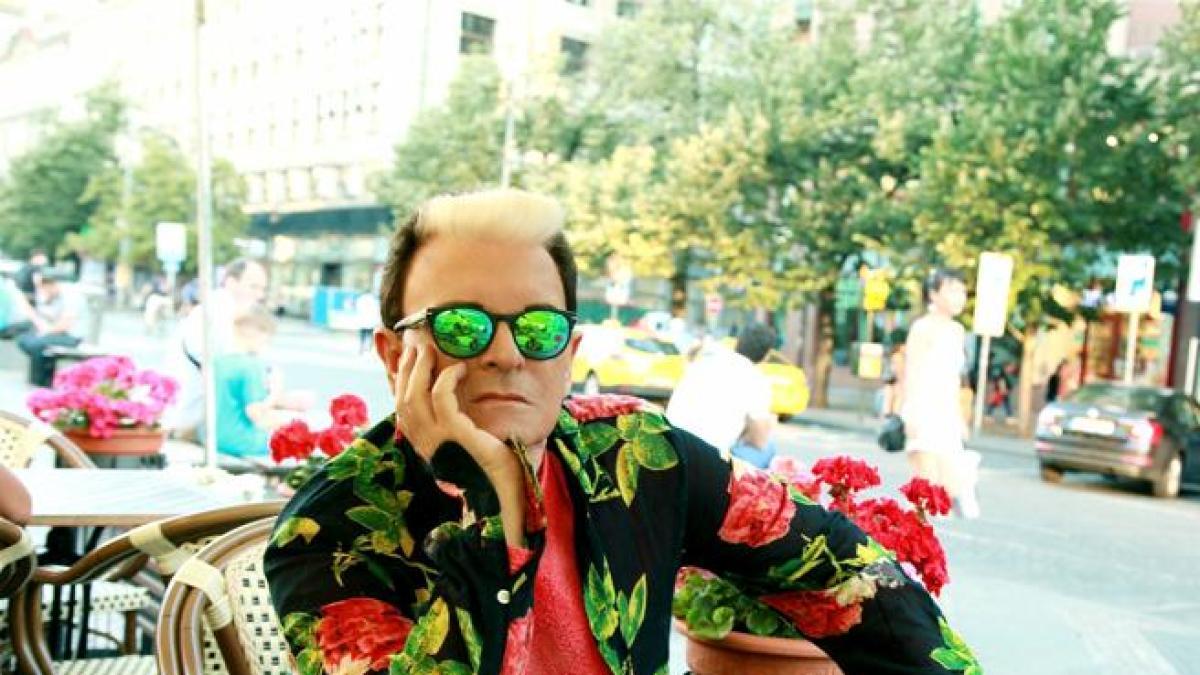

Cathy O’Neil: “L’AI non merita fiducia cieca, deve guadagnarsela”

governance ed etica dell’ai

Cathy O’Neil: “L’AI non merita fiducia cieca, deve guadagnarsela”

Secondo Cathy O’Neil, autrice e matematica statunitense ed esperta di auditing di sistemi di AI, l’affidabilità non è un fattore intrinseco degli algoritmi, ma qualcosa che va costruito in fase di progettazione e continuamente valutato e monitorato attraverso una matrice etica e singole “cabine di pilotaggio” per ciascun sistema.

L’intelligenza artificiale ha dimostrato capacità sbalorditive in ambienti chiusi e definiti, come negli algoritmi per il gioco degli scacchi o del Go (antico gioco da tavolo asiatico noto per la sua estrema complessità combinatoria). Il loro successo risiede in regole molto semplici, una chiara definizione di vittoria e un unico caso d’uso specifico.

Tuttavia, nel momento in cui l’AI viene integrata in sistemi decisionali complessi del mondo reale, dall’assistenza sanitaria all’automazione industriale, emerge l’interrogativo cruciale: possiamo fidarci di questi sistemi?

Per la matematica e scrittrice statunitense Cathy O’Neil, autrice del best seller “Armi di distruzione matematica” – opera che le è valsa l’Euler Book Prize della Mathematical Association of America nel 2019 – e opinionista per Bloomberg View, la risposta è un netto no: la fiducia non va concessa all’AI, ma deve essere guadagnata.

O’Neil, che fa parte del comitato consultivo della Harvard Data Science Review e si occupa attivamente di revisione e valutazione dei rischi (auditing) di soluzioni di AI e algoritmi, sostiene che l’enorme potere di questi sistemi ci impone di non volare “alla cieca”.

La sua metodologia di revisione si fonda su un’unica, fondamentale domanda, da porsi incessantemente: “Per chi fallisce questo sistema?“

La trappola della definizione di successo

Un algoritmo o un sistema di AI è, per definizione, un sistema predittivo: cerca di prevedere il futuro basandosi sull’analisi di schemi e dati storici. Per costruire un sistema predittivo funzionante, sono necessari due elementi fondamentali: una mole di dati storici pertinenti e una definizione di successo molto specifica. Il problema, secondo O’Neil, risiede nella scelta di questa definizione.

“Mentre l’individuo può definire il successo in base alle proprie esigenze (ad esempio, scegliere un vestito per una conferenza professionale ), quando il sistema è applicato a una collettività o in un contesto industriale, emergono molteplici stakeholder. Chi detiene il potere di costruire e implementare l’algoritmo finisce per imporre una definizione di successo che funziona per sé stesso, anche se in conflitto con gli obiettivi degli altri attori coinvolti”, spiega.

Il caso Optum: quando l’obiettivo del progetto e dell’algoritmo non coincide

Un esempio lampante di questo conflitto si riscontra nel settore sanitario statunitense, dove una compagnia (Optum) intendeva identificare i pazienti con problemi medici complessi per offrire loro consulenza e prevenire trattamenti inutili

Il criterio di “complessità” doveva mirare, nelle intenzioni dell’azienda, a individuare specificamente a pazienti con problemi sanitari multipli e interconnessi (come diabete e malattie cardiache) il cui trattamento poteva portare a cure tra loro in conflitto e quindi inutilmente costose e dannose per il paziente.

Il fine ultimo, per la compagnia assicurativa, era proprio quello di connettere questi pazienti con consulenza personalizzata (concierge advice) per prevenire tali conflitti e, di conseguenza, ridurre i costi.

Ma l’auditing del sistema ha permesso di riscontrare una discrepanza tra lo scopo iniziale del progetto e lo scopo per cui era stato addestrato l’algoritmo.

“Optum non ha impiegato la definizione di successo che si era prefissata. L’obiettivo era la gestione di ‘medicina complessa’: offrire consulenza a chi presentasse problemi medici complessi. Hanno scelto di ricorrere a quello che definiamo un proxy: qualcosa di strettamente correlato all’obiettivo, ma che non è la stessa cosa. E il proxy adottato, perché più facilmente accessibile per gli assicuratori, è stato il prezzo, ossia il costo storico dei trattamenti”, spiega.

Poiché i pazienti afroamericani erano notoriamente sotto trattati per i loro problemi complessi in passato, non risultavano “costosi” al sistema. Di conseguenza, l’algoritmo addestrato su dati passati ha sistematicamente negato l’offerta di aiuto a questi pazienti.

L’errore critico non era un “bias nei dati” in senso stretto (i dati riflettevano la realtà storica), ma l’utilizzo di una definizione di successo sbagliata (il costo anziché la complessità medica) che ha perpetuato la disuguaglianza. Solo dopo essere stato riaddestrato con l’obiettivo corretto, il numero di pazienti afroamericani a cui è stata offerta assistenza è raddoppiato.

Quando l’algoritmo ignora il contesto e i fattori esterni: l’esempio del Value Added Model (VAM) statunitense

Un altro esempio che riporta O’Neil riguarda il Value Added Model (VAM) negli Stati Uniti, un algoritmo concepito per valutare gli insegnanti in base alla performance attesa e reale degli studenti nei test standardizzati.

L’obiettivo politico era apparire severi e affrontare il divario di rendimento, ma il VAM ha fallito proprio per gli stakeholder più critici. Il modello era costruito per isolare il presunto “valore aggiunto” dall’insegnante, ma si è dimostrato altamente suscettibile a variazioni casuali e a fattori esterni al controllo del docente.

Di conseguenza l’algoritmo ha penalizzato in modo quasi arbitrario gli insegnanti delle scuole pubbliche in aree urbane, dove gli studenti, pur progredendo significativamente nel contesto della loro situazione di partenza, non raggiungevano i punteggi attesi basati su medie nazionali.

Il VAM, pur misurando una variabile oggettiva (il punteggio del test), ha prodotto un risultato iniquo: invece di aiutare a migliorare la qualità dell’istruzione dove era più necessaria, ha portato al licenziamento o alla demotivazione di insegnanti che lavoravano nelle scuole più complesse, peggiorando le disuguaglianze anziché risolverle, a causa di una definizione di successo troppo stretta che ignorava i complessi fattori socio-economici di contesto.

La matrice etica come strumento di mappatura dei rischi degli algoritmi di AI

Questi esempi hanno evidenziato come spesso l’errore algoritmico risiede nella definizione di successo e non solo in un errore tecnico dei dati.

Cathy O’Neil sostiene che il 90% del processo di revisione (audit) di un sistema di AI non è un esercizio di data science, ma di identificazione delle vulnerabilità.

L’approccio suggerito è costruire una “matrice etica“, uno strumento di previsione dei fallimenti che mappa i rischi. Le righe della matrice sono occupate dagli stakeholder identificati, mentre le colonne ospitano le diverse preoccupazioni, che vanno dalle categorie classiche (falso negativo, falso positivo) a quelle più sottili, come la violazione della privacy, la demotivazione o l’iniquità.

L’obiettivo della matrice non è fornire soluzioni immediate, ma portare alla luce i potenziali disastri e i “punti di rottura” (deal breakers) che un algoritmo può innescare, prima che sia operativo.

Le conversazioni che alimentano la matrice devono essere non tecniche, ma focalizzate esclusivamente sull’impatto umano e operativo.

“Occorre partire dalla definizione di stakeholder. Quando penso a chi siano gli stakeholder di sistema mi pongo sempre la stessa domanda: chi sono le persone la cui vita potrebbe venire significativamente sconvolta o danneggiata se il sistema fallisse? Chiunque rientri in questa definizione deve essere considerato stakeholder del sistema”, spiega.

La matrice etica espone i conflitti di ottimizzazione insiti in ogni sistema predittivo. Nel mondo reale, l’ottimizzazione di una variabile (ad esempio, la sicurezza) è spesso in diretta opposizione con l’ottimizzazione di un’altra (ad esempio, l’efficienza).

Questo si manifesta come un dilemma etico inevitabile. Un sistema di assunzione basato sull’AI, ad esempio, non può minimizzare contemporaneamente due tipi di errori: i falsi negativi (quando un candidato qualificato viene scartato, con danno per il candidato e potenziale perdita di talento per l’azienda) e i falsi positivi (quando un candidato non idoneo viene assunto, con danno economico e operativo per l’azienda).

“La matrice etica costringe gli stakeholder a confrontarsi con questo bilanciamento: quale dei due errori è considerato più tollerabile per la missione aziendale? Questa decisione, che definisce la ‘giustizia’ intrinseca del sistema, non è una formula matematica, ma una scelta politica e strategica che deve essere concordata in modo trasparente prima che l’AI sia autorizzata a operare”, spiega O’Neil.

La soluzione: costruire la cabina di pilotaggio di ogni sistema di intelligenza artificiale

Una volta che la matrice etica ha portato alla luce i potenziali fallimenti e i relativi dilemmi morali, il passo successivo per sistemi di AI degni di fiducia è la progettazione di un sistema di monitoraggio continuo.

O’Neil ricorre all’analogia della cabina di pilotaggio (cockpit) di un aereo per chiarire l’obiettivo: il pilota non monitora quanto bene sta volando l’aereo, ma monitora ogni potenziale modo in cui l’aereo potrebbe schiantarsi. Ogni quadrante misura una modalità di fallimento (ad esempio, pressione dell’olio, temperatura del motore), non una metrica di successo.

L’AI, sottolinea O’Neil, ha bisogno di una propria cabina di pilotaggio per monitorare costantemente i danni. Il processo di progettazione è diretto e non tecnico: i “quadranti” di monitoraggio nascono direttamente dalle celle “rosse” della matrice etica, ovvero dai problemi che gli stakeholder hanno identificato come importanti, probabili e inaccettabili.

Invece di monitorare la sola accuratezza complessiva (che interessa al venditore), la cabina di pilotaggio deve tracciare le metriche che interessano gli stakeholder, come il tasso di falsi positivi o falsi negativi per ogni specifico gruppo di utenti.

Misurare l’impatto significa anche misurare il divario tra i diversi gruppi di stakeholder. Ad esempio, in un algoritmo di assunzione, un quadrante essenziale non misurerà solo quanti candidati in totale vengono assunti (l’accuratezza), ma il divario di genere o etnico nel tasso di ammissione. Se l’algoritmo mantiene un’alta accuratezza complessiva, ma il tasso di falsi negativi per un gruppo demografico specifico aumenta, il sistema sta fallendo per quel gruppo e la cabina di pilotaggio deve segnalare l’anomalia.

L’affidabilità si guadagna: il monitoraggio continuo come base della responsabilità AI

Il framework di audit proposto da Cathy O’Neil offre un modello robusto per qualsiasi settore in cui le decisioni algoritmiche hanno un impatto critico.

L’AI, compresi i moderni Large Language Models (LLM) che introducono sfide aggiuntive come l’inconsistenza e le “allucinazioni”, è un sistema efficace solo dove esistono regole semplici, un unico caso d’uso e una chiara definizione di successo (come negli scacchi o nel Go).

Nelle sfide del mondo reale, complesse e sfumate, l’AI è un sistema che prende decisioni basato sulla storia, non esente da fallimenti. L’unico modo per renderlo un partner affidabile è sottoporlo a un rigido controllo di processo, fermo restando che “ci sono scenario in cui in bot di AI non potrà mai avere successo e in cui non dovrebbe nemmeno essere usato, come nel caso della salute mentale”.

L’esortazione finale della matematica statunitense per le organizzazioni che adottano l’AI è chiara: non fidarsi di un black box che promette accuratezza al 99% e non assumere che un sistema altamente accurato sia “giusto”, sia dal punto di vista del successo ma, soprattutto, per gli stakeholder coinvolti.

Il monitoraggio continuo, guidato da una chiara definizione dei potenziali disastri, è l’unico modo per un’AI responsabile. La cabina di pilotaggio e il suo framework di audit consentono all’azienda di intervenire in modo mirato e dimostrare che l’affidabilità non è una caratteristica innata dell’AI, ma un risultato che deve essere attivamente mantenuto e guadagnato.

Solo attraverso questa vigilanza attiva e continua l’AI potrà operare in modo etico e sostenibile.

L'articolo Cathy O’Neil: “L’AI non merita fiducia cieca, deve guadagnarsela” proviene da Innovation Post.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0

-1754133631392.png--valerio_minato_svela_il_volto_in_movimento_del_monviso_sotto_le_stelle.png?1754133631616#)