Il futuro dell’automazione è sempre più software-defined: siamo pronti a governarlo?

SCENARI

Il futuro dell’automazione è sempre più software-defined: siamo pronti a governarlo?

La fabbrica del futuro sarà definita dal software. Ma la transizione dall’era del ferro a quella del codice è tutt’altro che scontata. Dall’evento “Oltre l’automazione: verso la Software Defined Factory” gli esperti avvertono: la tecnologia – dai Virtual PLC all’AI fino al quantum computing – corre veloce, ma senza una rivoluzione culturale su alcuni grandi temi – gestione del dato, modelli di management, collaborazione di filiera e modelli di business – l’industria rischia di perdere la sfida della competitività globale.

L’ex fornace del Museo del Patrimonio Industriale di Bologna, un tempo cuore pulsante della produzione di “hardware” per eccellenza come i laterizi, ha fatto da cornice a un dibattito sul futuro dell’industria manifatturiera. A confrontarsi, durante l’evento “Oltre l’automazione: verso la Software Defined Factory” organizzato dall’Industrial Innovation Lab e promosso da Sew Eurodrive, un panel di esperti del mondo accademico, della ricerca, dell’industria tecnologica e della cultura d’impresa.

Il futuro – e questa appare ormai una certezza – sarà sempre più governato dal software. Ma sbaglierebbe chi pensi che si tratta solo di una semplice evoluzione tecnologica, perché siamo difronte a un cambiamento sistemico che impone a imprenditori, manager e policy maker di ripensare modelli di business, architetture tecnologiche e soprattutto la cultura aziendale.

La virtualizzazione come primo passo concreto

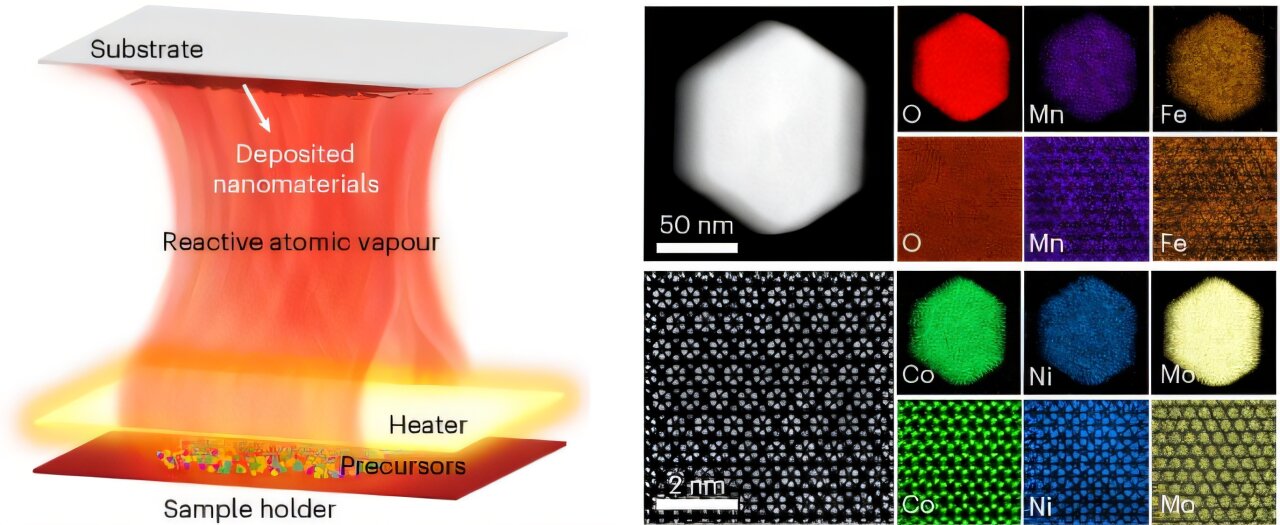

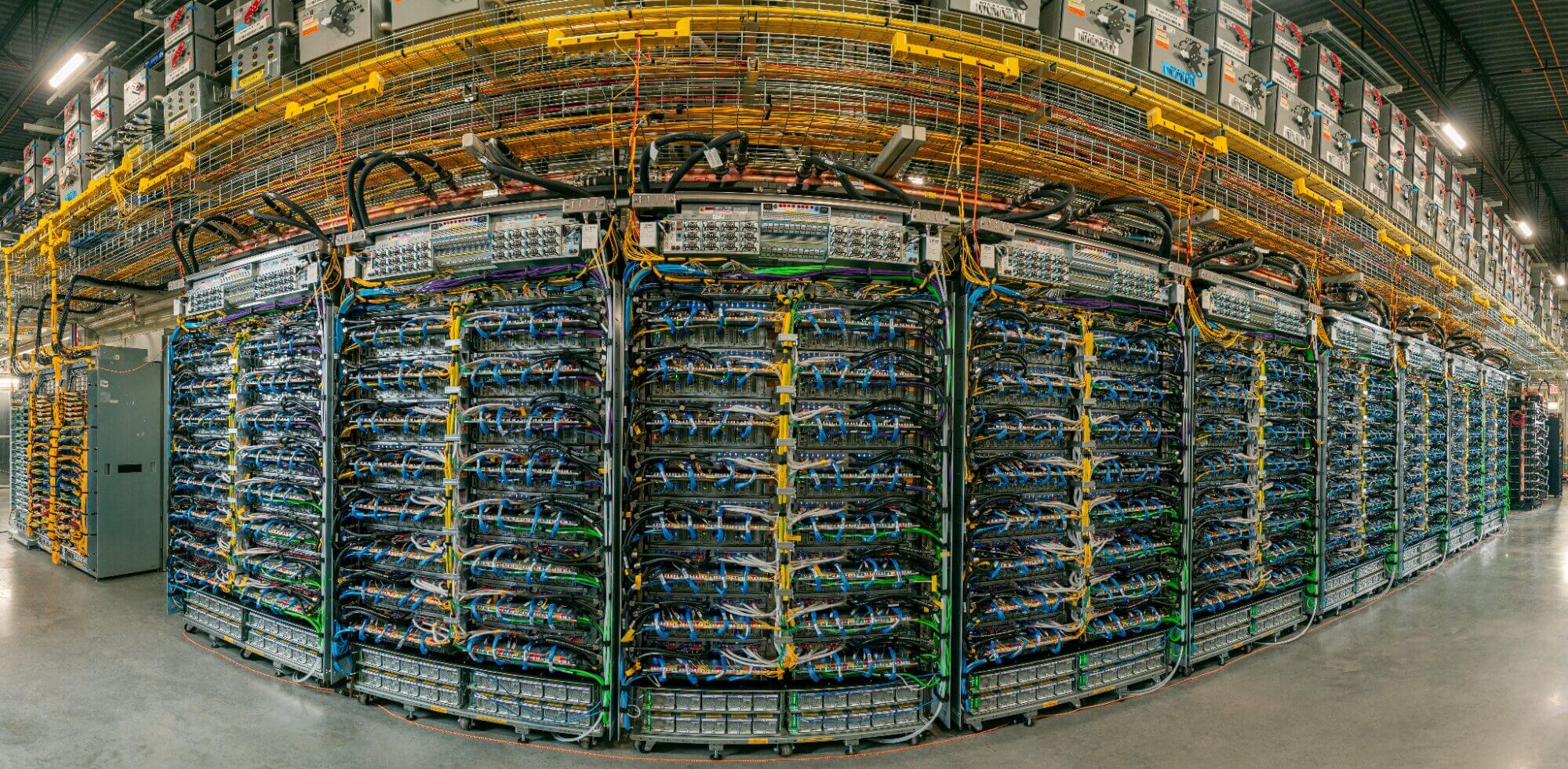

Il cammino verso l’automazione definita dal software è già iniziato e uno dei suoi pilastri è la virtualizzazione dei controllori logici programmabili. Paolo Bellavista, professore al Dipartimento di Informatica dell’Università di Bologna, ha descritto la Software-Defined Automation (SDA) come “un sogno che si realizza, un passo per certi versi inevitabile”. Il suo intervento si è concentrato sul caso dei Virtual PLC, software che eseguono i task di automazione su nodi virtualizzati anziché sull’hardware dedicato del PLC tradizionale.

I vantaggi sono evidenti: svincolarsi dal lock-in di un singolo fornitore hardware e beneficiare dell’accelerazione prestazionale dell’hardware “general purpose”. Ma la strada non è priva di ostacoli. Bellavista ha messo in guardia dai rischi di un nuovo lock-in, questa volta a livello software o di hypervisor, e ha presentato dati concreti da un progetto di ricerca svolto con importanti end-user del territorio come Sacmi e IMA. Gli esperimenti hanno dimostrato come le prestazioni di un Virtual PLC dipendano in modo critico dalla configurazione del software sottostante: “Cambiando la configurazione del kernel Linux Real Time, il jitter del sistema può passare da picchi di 800 microsecondi, inaccettabili in un ambiente di controllo industriale, a un valore gestibile di 11 microsecondi”. Un dato che sottolinea la necessità di competenze ibride IT/OT e di un approccio basato sulla sperimentazione. L’apertura, per i grandi player, si configura come “una necessità per avere comunità ampie che controllino le infinite possibilità di errore”.

Il digital twin: due approcci a confronto

A fare da ponte tra il mondo fisico e quello virtuale è il Digital Twin, tema centrale dell’intervento di Giuseppe Padula, co-chair del Software-defined Manufacturing Working Group del Digital Twin Consortium. Padula ha messo in luce l’esistenza di due filosofie speculari. Da una parte l’approccio europeo, promosso dall’IDTA (Industrial Digital Twin Association), che parte dal basso, dall’asset fisico, e gli costruisce sopra un involucro digitale noto come Asset Administration Shell. È un approccio che Padula definisce “orientato al ferro”, tipico della tradizione manifatturiera europea.

Dall’altra parte c’è l’approccio americano del Digital Twin Consortium, che è top-down, “orientato al business”. Qui si parte dal processo di business che si vuole abilitare e si integrano le tecnologie digitali necessarie, trattando l’asset fisico come una componente del processo software, in una logica di Industrial DevOps, la filosofia secondo cui i processi fisici e industriali vengono gestiti applicando le stesse metodologie agili, automatizzate e basate sui dati del moderno sviluppo software. “Quando l’end user passa da un mercato digitale al fisico perché gli serve, non perché è interessato al fisico, ma perché deve passare per il proprio processo di business attraverso il fisico, allora lì si muove attraverso l’Industrial DevOps”, ha spiegato Padula, citando l’esempio di Amazon. La sfida per l’industria italiana ed europea è mediare tra queste due visioni, radicando le nuove tecnologie digitali “sulle caratteristiche del territorio tecnologico”.

Del resto, spiega, “oggi è il cliente a scegliere il tempo di consegna e quindi la produzione in linea non funziona più”. Serve un approccio che integri due variabili simultanee: prodotto e cliente, estendendo la lavorazione su due coordinate anziché una sola.

La fiducia come nuovo vantaggio competitivo

Se la virtualizzazione è un tassello, l’intelligenza artificiale è il motore che promette di rendere le fabbriche realmente autonome. Ma con l’aumentare dell’autonomia, emerge una questione fondamentale: la fiducia. Paolo Meregalli, co-founder di 255 H.E.C., ha dedicato il suo intervento proprio a questo binomio, partendo da una premessa: l’AI attuale, basata su Large Language Models, non comprende, ma ripete pattern statistici. Questo genera rischi come le “allucinazioni” e, soprattutto, i bias.

Attraverso esempi noti, dal chatbot diventato nazista al sistema di assunzioni che discriminava le donne, Meregalli ha evidenziato come la qualità del dato sia cruciale. “Un tempo il codice era neutrale rispetto ai dati. Oggi i dati riscrivono il codice, e se i dati fossero corrotti?”, ha domandato. In una fabbrica software-defined, dove l’AI può modificare il comportamento di una macchina in tempo reale, la fiducia non è un optional. “Il dato diventa il prodotto”, ha affermato, e la sua qualità e integrità devono essere garantite sin dalla sua generazione. Un approccio, questo, rafforzato anche dal nuovo Regolamento Macchine (2023/1230), che dal 2027 introdurrà requisiti essenziali di sicurezza legati alla cybersecurity e al software, imponendo di valutare anche i rischi “ragionevolmente prevedibili” di una macchina che si auto-evolve.

Emanuele Frontoni, professore dell’Università di Macerata e co-direttore del laboratorio VRAI (Vision, Robotics & Artificial Intelligence Lab), ha portato esempi concreti di come Computer Vision e GenAI stiano già creando nuove forme di collaborazione uomo-macchina. Gli esempi spaziano dal controllo qualità estetico per i calci dei fucili in Benelli all’assistenza tecnica per i robot di Campetella basata sull’analisi di manuali multimediali. Ma anche da questi casi d’uso avanzati emergono criticità: “Nelle aziende troviamo un buco nero sulle immagini, nessuno le ha mai descritte”, ha ammonito Frontoni, sottolineando come la mancanza di una cultura del dato rischi di vanificare gli investimenti. Un altro rischio, ha aggiunto, deriva da “uno scellerato utilizzo inconsapevole interno di versioni gratuite di LLM”, che può portare a una pericolosa cessione di know-how.

Il monito finale è a non cadere nella trappola dell’antropomorfizzazione: “Non dobbiamo umanizzare questi sistemi. Quando usate il tostapane non gli dite ‘ben fatto, ottimo lavoro'”, ha concluso, ricordando che l’AI è “una macchina da usare in maniera consapevole”.

Oltre il determinismo: verso la qubit economy

Se l’AI gestisce la complessità attuale, il quantum computing promette di superarla. Roberto Siagri, CEO di Rotonium, ha introdotto il concetto di “Qubit Economy”, un cambiamento sistemico che non si limita a ottimizzare l’esistente, ma lo trasforma. “Perché ottimizzare un sistema che non funziona?”, ha esordito, riferendosi ai limiti dell’economia lineare. La logica quantistica, capace di gestire l’incertezza e simulare scenari multipli simultaneamente, apre a modelli produttivi adattivi e circolari.

“Il computer quantistico non ottimizza l’esistente: lo supera. È il primo passo verso un’economia che calcola relazioni invece di prodotti”, ha spiegato Siagri. La sua visione è quella di computer quantistici “edge”, piccoli e integrabili nelle fabbriche, una prospettiva che secondo la roadmap della sua azienda non è poi così lontana: “Nel 2027 già avremo qualche cosa che farà vedere alle imprese che si può fare”. Questo cambio di paradigma tecnologico è il presupposto per una nuova “grammatica operativa” basata su ecosistemi e “coopetizione”, dove il valore si sposta dalla vendita di prodotti all’erogazione di servizi.

La cultura come prerequisito fondamentale

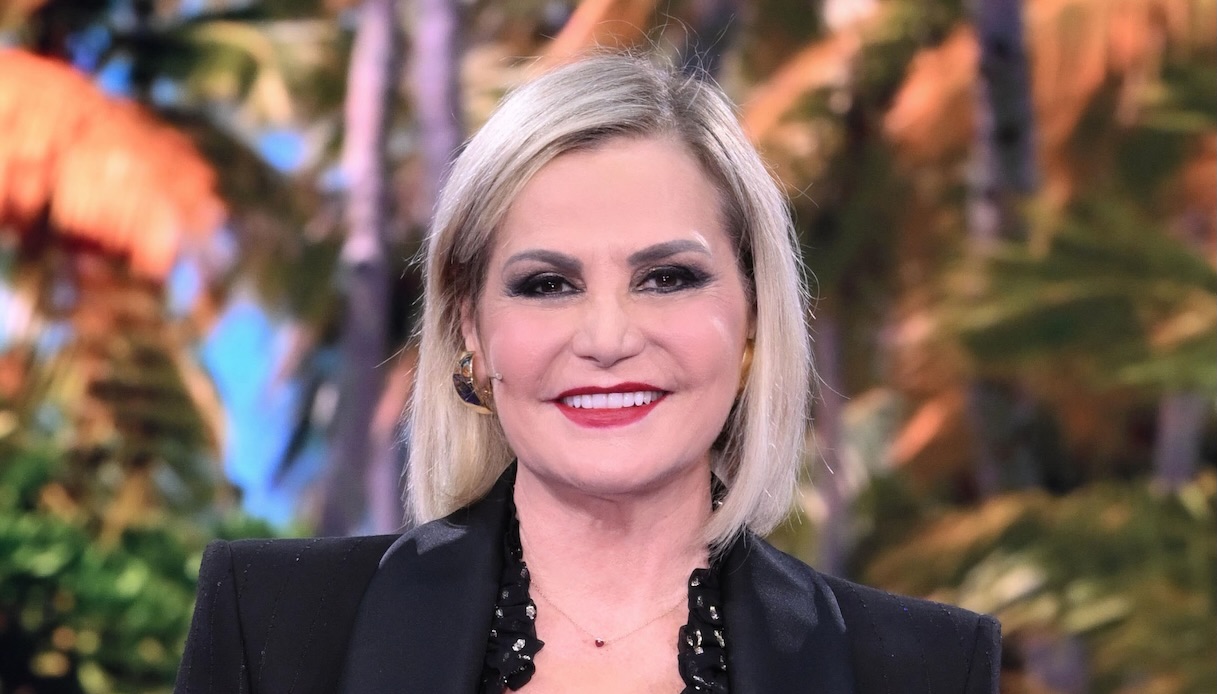

Tutte queste trasformazioni tecnologiche, però, rischiano di rimanere sterili senza un adeguato cambiamento culturale e manageriale. Questo è stato il messaggio trasversale di tutta la giornata, ma esplicitato con forza da Elena Tosca, direttore dell’Industrial Innovation Lab. “Siamo troppo abituati a pensare all’innovazione come qualcosa di tecnologico e palpabile. Ma la vera origine dell’innovazione è nella cultura che pervade l’organizzazione”, ha detto.

“La tecnologia può essere acquistata. La cultura deve essere costruita”, ha poi proseguito Tosca. Utilizzando l’esempio di Kodak, che “il digitale l’ha inventato” ma è fallita per una “cultura orientata alla protezione del core business”, Tosca ha mostrato come siano i valori, le credenze e i comportamenti a determinare il successo o il fallimento dell’innovazione. Le aziende che riescono a combinare capacità tecnologiche e leadership culturale, definite “Digital Masters”, sono secondo le ricerche del MIT mediamente il 26% più redditizie dei concorrenti.

Sulla stessa linea Vittorio D’Amato, direttore scientifico dell’Industrial Innovation Lab, ha evidenziato lo scollamento tra l’evoluzione tecnologica (Industria 5.0) e i modelli gestionali, fermi al “management 1.0”. Le tre caratteristiche irrinunciabili del manager del futuro, secondo D’Amato, sono la capacità di “inquadrare il compito in un contesto più ampio”, la “collaborazione” e il “pensiero sistemico”. Quest’ultimo, in particolare, significa superare la logica lineare causa-effetto per abbracciare la comprensione della circolarietà dei fenomeni. Come spiegato da D’Amato, il mondo non è lineare ma fatto di “circuiti di retroazione”: un manager dotato di pensiero sistemico non si limita a valutare il risultato immediato di una decisione, ma ne analizza le conseguenze a cascata, comprendendo come queste influenzeranno e modificheranno il sistema stesso nel tempo.

Il tema delle competenze e del divario culturale tra chi offre tecnologia e chi la deve utilizzare è stato al centro anche dell’intervento di Ferdinando Cannella, coordinatore della Industrial Robotics Facility dell’Istituto Italiano di Tecnologia (IIT). Cannella ha sottolineato come la principale barriera all’adozione della robotica nel tessuto delle PMI italiane sia proprio la complessità d’uso e la carenza di skill interne specializzate. “Le nostre microimprese non possono permettersi un esperto, un robotico per ogni robot che comprano”, ha osservato. La soluzione, secondo il ricercatore dell’IIT, risiede nella semplificazione, resa possibile da nuove interfacce basate sull’Intelligenza Artificiale. “Lo scopo è abbassare il livello di difficoltà e rendere più facile per qualsiasi azienda l’adozione di queste tecnologie”, ha spiegato, prefigurando un futuro in cui i robot potranno essere istruiti attraverso il linguaggio naturale. Questa semplificazione è anche la chiave per colmare il divario che spesso separa il mondo della ricerca dalle esigenze concrete delle imprese, che chiedono soluzioni pratiche e immediatamente utilizzabili, mentre “a volte noi ricercatori non siamo interessati a sviluppare qualcosa che non porti a una pubblicazione su Nature“.

Il tema della collaborazione, del “fare ecosistema”, è emerso come la vera chiave di volta. Daniele Vacchi, presidente degli Amici del Museo del Patrimonio Industriale di Bologna e tanti anni di esperienza nel mondo dei costruttori di macchinari, ha ricordato come la grande tradizione meccanica emiliana sia al contempo “la nostra ricchezza e il nostro limite”. Per competere a livello globale, la sfida non è più fare macchine più veloci, ma integrarle in sistemi complessi e cambiare i modelli di business. In un contesto dove la concorrenza arriva da Cina e USA, la frammentazione del tessuto industriale italiano richiede un salto culturale verso la condivisione di know-how e strategie.

E proprio su questo punto si è innestata la riflessione di Giorgio Ferrandino, Managing Director di SEW-Eurodrive, che ha offerto il punto di vista privilegiato di un grande fornitore di tecnologia. Per un’azienda abituata a produrre hardware, affrontare il paradigma software-defined è prima di tutto “un tema di sopravvivenza”. Ma non si tratta di una difesa passiva. Al contrario, significa entrare in questo nuovo mondo “con uno spirito aperto, collaborativo e trovare il modo di dare valore a quello che storicamente facciamo”. Questo impone un nuovo modo di fare impresa, basato su valori condivisi come “coesione, collaborazione ed etica professionale”. Per Ferrandino, parlare di ecosistemi ha senso solo se si riconosce che “le interdipendenze tra gli stakeholder non sono un’opzione, sono elementi fondanti”. In questo scenario, il ruolo del fornitore di tecnologia è quello di “aprire piste nuove”, sfruttando le finestre di opportunità create dal cambiamento tecnologico per guidare i clienti in una transizione che è tanto culturale quanto tecnologica, superando la “paura, tutta italiana, che il mio concorrente dall’altra parte della strada possa avvantaggiarsi della mia apertura”.

L'articolo Il futuro dell’automazione è sempre più software-defined: siamo pronti a governarlo? proviene da Innovation Post.

Qual è la tua reazione?

Mi piace

0

Mi piace

0

Antipatico

0

Antipatico

0

Lo amo

0

Lo amo

0

Comico

0

Comico

0

Furioso

0

Furioso

0

Triste

0

Triste

0

Wow

0

Wow

0

%20Bressanone%20Turismo_Max%20Rella%20(2).jpg)

-1749821006062.jpg--chivasso__al_via_la_manutenzione_straordinaria__lavori_su_strade_e_marciapiedi_fino_al_2_dicembre.jpg?1749821006101#)

-1754133631392.png--valerio_minato_svela_il_volto_in_movimento_del_monviso_sotto_le_stelle.png?1754133631616#)